Orthogonalität

Der Begriff Orthogonalität wird innerhalb der Mathematik in unterschiedlichen, aber verwandten Bedeutungen verwendet.

In der Elementargeometrie nennt man zwei Geraden oder Ebenen orthogonal (bzw. senkrecht), wenn sie einen rechten Winkel, also einen Winkel von 90°, einschließen.

In der linearen Algebra wird der Begriff auf allgemeinere Vektorräume erweitert: zwei Vektoren heißen zueinander orthogonal, wenn ihr Skalarprodukt null ist.

Diese Bedeutung wird auch auf Abbildungen zwischen Vektorräumen übertragen, die das Skalarprodukt und damit die Orthogonalität zweier Vektoren unverändert lassen.

Bezeichnungen

Der Begriff orthogonal (griechisch ὀρθός orthos „richtig, recht-“ und γωνία gonia „Ecke, Winkel“) bedeutet „rechtwinklig“. Gleichbedeutend zu rechtwinklig steht auch normal (lateinisch norma „Maß“, im Sinne des rechten Winkels). Das Wort „normal“ wird in der Mathematik aber auch mit anderen Bedeutungen verwendet. Senkrecht kommt vom Senkblei (Lot) und bedeutet ursprünglich nur orthogonal zur Erdoberfläche (lotrecht). Dieser Sachverhalt wird auch durch vertikal (lat. vertex „Scheitel“) ausgedrückt.

Man bezeichnet zwei Geraden, Ebenen oder Vektoren

und

,

die orthogonal bzw. nicht orthogonal zueinander sind, mit

bzw.

.

Basierend auf der englischen Bezeichnung perpendicular wird das

Orthogonalitätssymbol in HTML

mit ⊥ und in LaTeX

(innerhalb der Mathematik-Umgebung) mit \perp kodiert. Im Zeichenkodierungsstandard

Unicode

besitzt das Symbol ⊥ die Position U+22A5.

Orthogonalität in der Geometrie

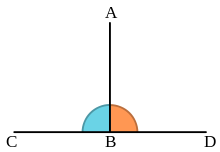

Elementargeometrie

In der Elementargeometrie heißen zwei Geraden oder Ebenen orthogonal, wenn sie einen rechten Winkel, d.h. einen Winkel von 90° einschließen. Dabei sind folgende Bezeichnungen gebräuchlich:

- Eine Gerade heißt Orthogonale (Normale) auf eine Ebene, wenn ihr Richtungsvektor ein Normalenvektor der Ebene ist.

- Eine Ebene heißt Orthogonale (Normalebene) einer Ebene, wenn ihr Normalenvektor in dieser Ebene liegt.

- Eine Gerade/Ebene heißt Orthogonale (Normale) an eine Kurve, wenn sie zur Tangente/Tangentialebene im Schnittpunkt orthogonal ist.

In einem orthogonalen Polygon (beispielsweise einem Rechteck) bilden je zwei benachbarte Seiten einen rechten Winkel, bei einem orthogonalen Polyeder (beispielsweise einem Quader) je zwei benachbarte Kanten und damit auch benachbarte Seitenflächen.

Analytische Geometrie

Vektoren

Den Winkel zweier Vektoren

und

im kartesischen

Koordinatensystem kann man über das Skalarprodukt

berechnen. Dabei bezeichnen

und

jeweils die Längen

der Vektoren und

den Kosinus des von den beiden Vektoren eingeschlossenen Winkels. Bilden zwei

Vektoren

und

einen rechten Winkel, dann gilt

.

Zwei Vektoren sind somit zueinander orthogonal, wenn ihr Skalarprodukt gleich null ist. Der Nullvektor ist dabei zu allen Vektoren orthogonal.

Eine Menge von Vektoren

wird als paarweise orthogonal bezeichnet, wenn für alle

gilt, dass

und

orthogonal zueinander sind.

Geraden und Ebenen

Zwei Geraden in der Ebene sind dann orthogonal, wenn ihre Richtungsvektoren orthogonal sind. Im Raum oder in höheren Dimensionen ist kein Schnittpunkt nötig. Zwei Geraden können auch dann orthogonal sein, wenn sie windschief zueinander sind. Eine Gerade und eine Ebene im Raum sind orthogonal, wenn der Richtungsvektor der Geraden orthogonal zu jedem Vektor in der Ebene ist.

Zwei Ebenen im euklidischen Raum sind orthogonal, wenn es eine Gerade gibt, die in einer der beiden Ebenen enthalten und orthogonal zur zweiten ist.

Sind zwei Geraden in der euklidischen Ebene durch die Gleichungen

und

gegeben, so sind sie genau dann orthogonal, wenn

ist, oder äquivalent: wenn

gilt, denn genau dann sind mit

ihre Richtungsvektoren orthogonal.

Synthetische Geometrie

In der synthetischen Geometrie kann eine Orthogonalität durch die axiomatische Beschreibung einer Orthogonalitätsrelation zwischen Geraden auf gewissen affinen Inzidenzebenen eingeführt werden.

Orthogonalität in der linearen Algebra

Orthogonale und orthonormale Vektoren

In der linearen Algebra werden in einer Erweiterung des Begriffs euklidischer Raum

auch mehrdimensionale Vektorräume über den reellen oder komplexen Zahlen

einbezogen, für die ein Skalarprodukt

definiert ist. Das Skalarprodukt zweier Vektoren

und

ist dabei eine Abbildung, die gewisse

Axiome erfüllen muss und typischerweise in der Form

geschrieben wird. Allgemein gelten dann zwei Vektoren

und

aus einem solchen Skalarproduktraum

als orthogonal zueinander, wenn das Skalarprodukt der beiden Vektoren

gleich null ist, das heißt, wenn

gilt. Beispielsweise sind im Raum

die beiden Vektoren

und

orthogonal bezüglich des Standardskalarprodukts,

da

ist. Eine Menge von Vektoren nennt man dann orthogonal oder Orthogonalsystem, wenn

alle darin enthaltenen Vektoren paarweise orthogonal zueinander sind. Wenn

zusätzlich alle darin enthaltenen Vektoren die Norm eins besitzen,

nennt man die Menge orthonormal oder ein Orthonormalsystem.

Eine Menge von orthogonalen Vektoren, die alle vom Nullvektor verschieden sind,

ist immer linear

unabhängig und bildet deshalb eine Basis

der linearen

Hülle dieser Menge. Eine Basis eines Vektorraums aus orthonormalen Vektoren

wird dementsprechend Orthonormalbasis

genannt. Für je zwei Vektoren

einer Orthonormalbasis gilt dabei

,

wobei

das Kronecker-Delta

bezeichnet. Endlichdimensionale Skalarprodukträume und Hilberträume besitzen immer

eine Orthonormalbasis. Bei endlichdimensionalen Vektorräumen und bei separablen

Hilberträumen kann man eine solche mit Hilfe des Gram-Schmidtschen

Orthonormalisierungsverfahren finden. Ein Beispiel für eine Orthonormalbasis

ist die Standardbasis

(oder kanonische Basis)

des dreidimensionalen Raumes

.

Orthogonale Funktionen

Der Begriff Vektorraum kann dahingehend verallgemeinert werden, dass auch

gewisse Funktionenräume

als Vektorräume behandelt werden können, und Funktionen werden dann als Vektoren

angesehen. Zwei Funktionen

und

eines Skalarproduktraums heißen dann zueinander orthogonal, wenn

gilt. Zum Beispiel ist das L2-Skalarprodukt

für stetige reellwertige Funktionen auf einem Intervall

durch

definiert. Bezüglich dieses Skalarprodukts sind beispielsweise auf dem

Intervall

die beiden Funktionen

und

zueinander orthogonal, denn es gilt

.

In vollständigen Skalarprodukträumen, sogenannten Hilberträumen, lassen sich so orthogonale Polynome und Orthogonalbasen bestimmen. Allerdings sind viele interessante Räume, wie etwa die L2-Räume, unendlichdimensional, siehe dazu Hilbertraumbasis. In der Quantenmechanik bilden auch die Zustände eines Systems einen Vektorraum und entsprechend spricht man dort auch von orthogonalen Zuständen.

Orthogonale Matrizen

Eine quadratische, reelle Matrix

heißt orthogonale Matrix, wenn sie mit dem Skalarprodukt verträglich ist, das

heißt wenn

für alle Vektoren

gilt. Eine Matrix

ist genau dann orthogonal, wenn ihre Spalten (oder ihre Zeilen), als Vektoren

aufgefasst, zueinander orthonormal (nicht nur orthogonal) sind. Äquivalent dazu

ist die Bedingung

bzw.

.

Orthogonale Matrizen beschreiben Drehungen

und Spiegelungen

in der Ebene oder im Raum. Die Menge aller orthogonalen Matrizen der Größe

bildet die orthogonale

Gruppe

.

Die Entsprechung bei Matrizen mit komplexen Einträgen heißt unitäre Matrix.

Orthogonale Abbildungen

Sind

und

zwei reelle Skalarprodukträume,

dann heißt eine Abbildung

orthogonal, wenn

für alle Vektoren

gilt. Eine orthogonale Abbildung erhält damit das Skalarprodukt zweier Vektoren

und bildet so orthogonale Vektoren auf orthogonale Vektoren ab. Eine Abbildung

zwischen endlichdimensionalen Skalarprodukträumen ist genau dann orthogonal,

wenn ihre Matrixdarstellung

bezüglich einer Orthonormalbasis eine orthogonale Matrix ist. Weiter ist eine

orthogonale Abbildung eine Isometrie

und erhält somit auch Längen und Abstände von Vektoren.

Orthogonale Abbildungen sind nicht zu verwechseln mit zueinander orthogonalen Abbildungen. Dabei handelt es sich um Abbildungen, die selbst als Vektoren aufgefasst werden und deren Skalarprodukt gleich null ist. Abbildungen zwischen komplexen Skalarprodukträumen, die das Skalarprodukt erhalten, werden als unitäre Abbildungen bezeichnet.

Orthogonale Projektionen

Ist

ein endlichdimensionaler reeller oder komplexer Vektorraum mit einem

Skalarprodukt, so gibt es zu jedem Untervektorraum

die Projektion entlang des orthogonalen Komplements von

,

welche Orthogonalprojektion auf

genannt wird. Sie ist die eindeutig bestimmte lineare Abbildung

mit der Eigenschaft, dass für alle

und

für alle

gilt. Ist

ein unendlichdimensionaler Hilbertraum,

so gilt diese Aussage mit dem Projektionssatz

entsprechend auch für abgeschlossene

Untervektorräume

.

In diesem Fall kann

stetig gewählt werden.

Orthogonalität in normierten Räumen

In einem Skalarproduktraum

ist

äquivalent zu

für alle Skalare

.

Das motiviert folgende Definition:

- Für

aus einem normierten Raum

sei

für alle

Dieser Orthogonalitätsbegriff in normierten Räumen ist wesentlich schwächer

als in Skalarprodukträumen. Im Allgemeinen ist Orthogonalität weder symmetrisch

noch additiv, das heißt aus

folgt im Allgemeinen nicht

und aus

und

folgt im Allgemeinen nicht

.

Dieser Umstand führt zu weiteren Begriffsbildungen, denn man wird sich für solche normierten Räume interessieren, in denen die Orthogonalität additiv ist. Es stellt sich heraus, dass das genau die glatten normierten Räume sind.

Anwendungen

Orthogonalität wird in vielen Anwendungen genutzt, weil dadurch Berechnungen einfacher oder robuster durchgeführt werden können. Beispiele sind:

- die Fourier-Transformation und die Wavelet-Transformation in der Signalverarbeitung

- QR-Zerlegungen von Matrizen zur Lösung von Eigenwertproblemen

- die Gauß-Quadratur zur numerischen Berechnung von Integralen

- orthogonale Codes, etwa der Walsh-Code, in der Kanalkodierung

- das Orthogonalverfahren zur Vermessung in der Geodäsie

Siehe auch

- Parallelität (Geometrie)

- Orthogonalitätsrelationen in der Gruppentheorie

© biancahoegel.de

Datum der letzten Änderung: Jena, den: 22.02. 2023